Котики под завалами: как искусственный интеллект ввел в заблуждение украинцев

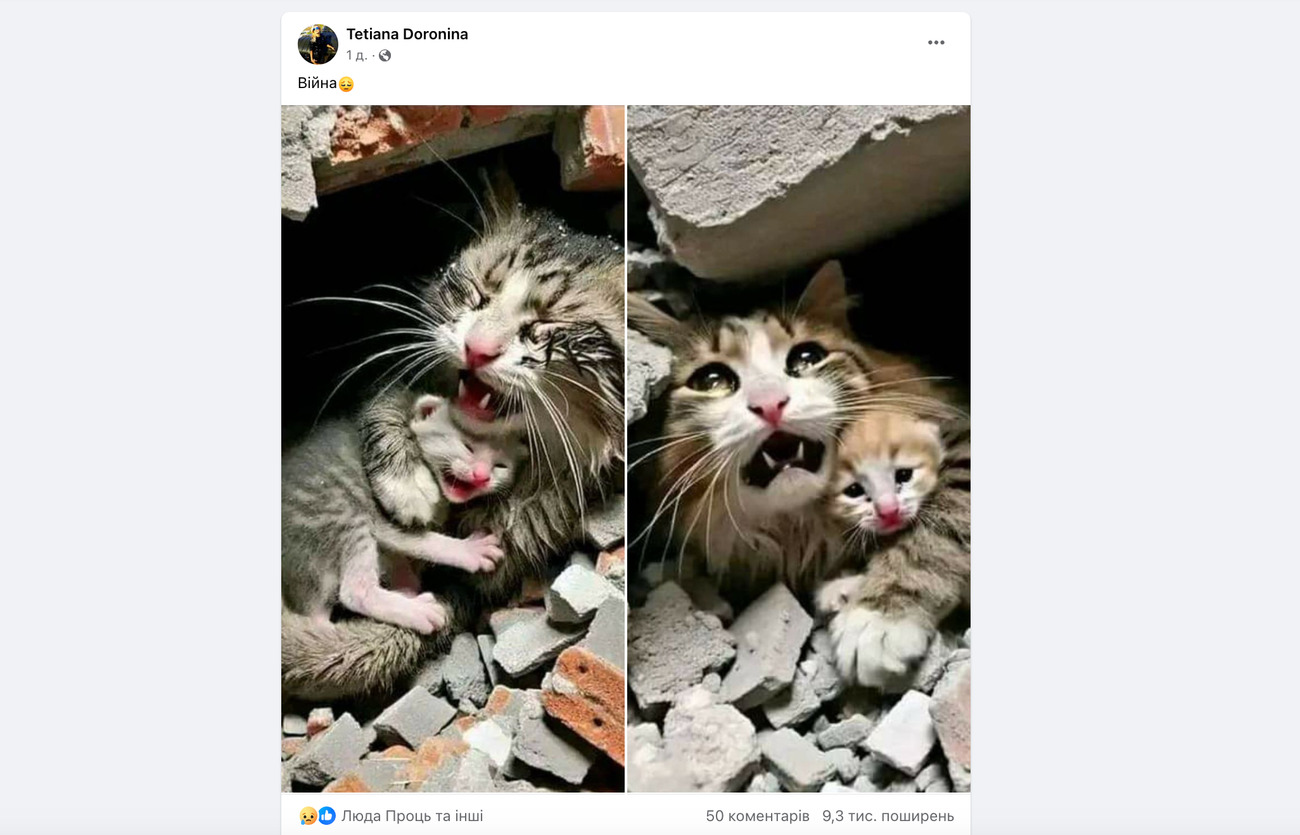

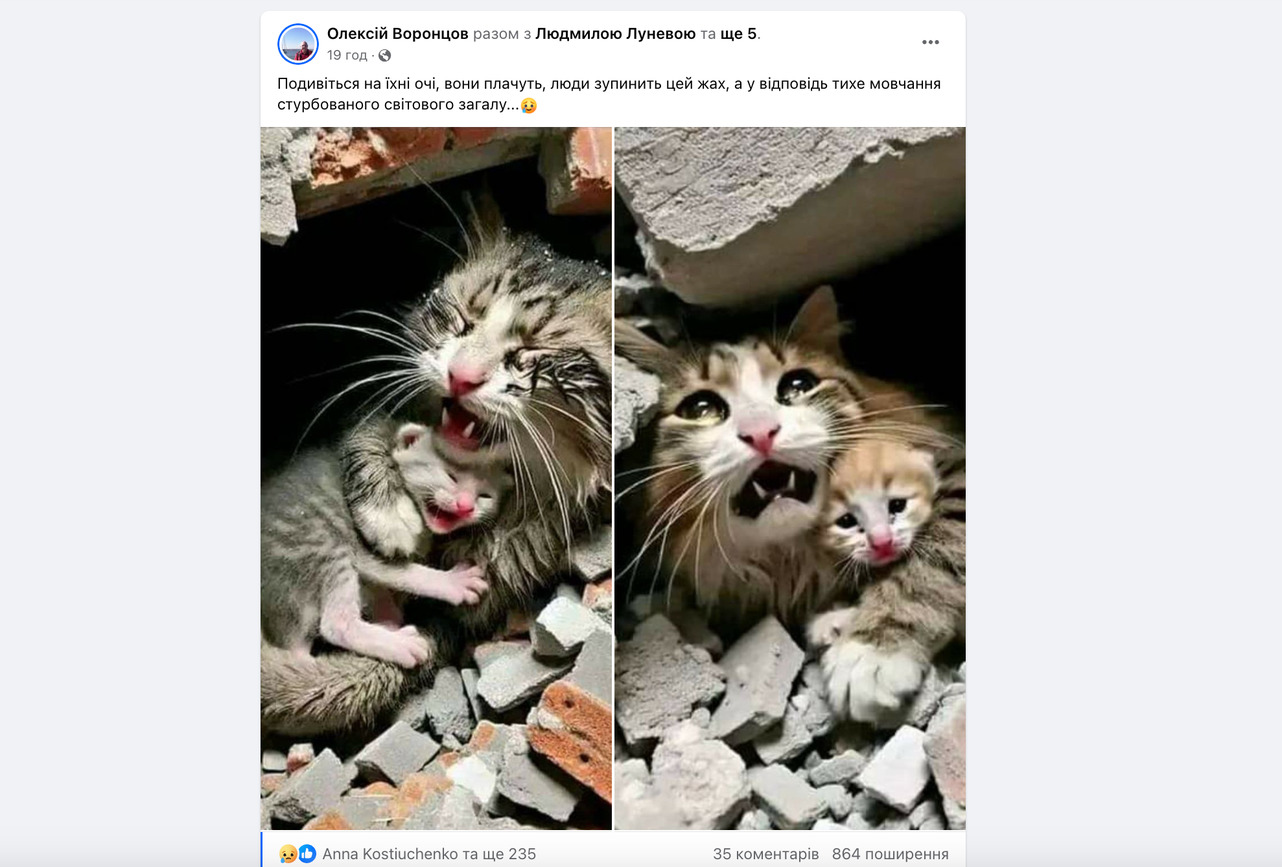

Некоторые пользователи утверждали, что животные пострадали из-за российских атак на Украину: так, созданные нейросетью фотографии распространили нардепа

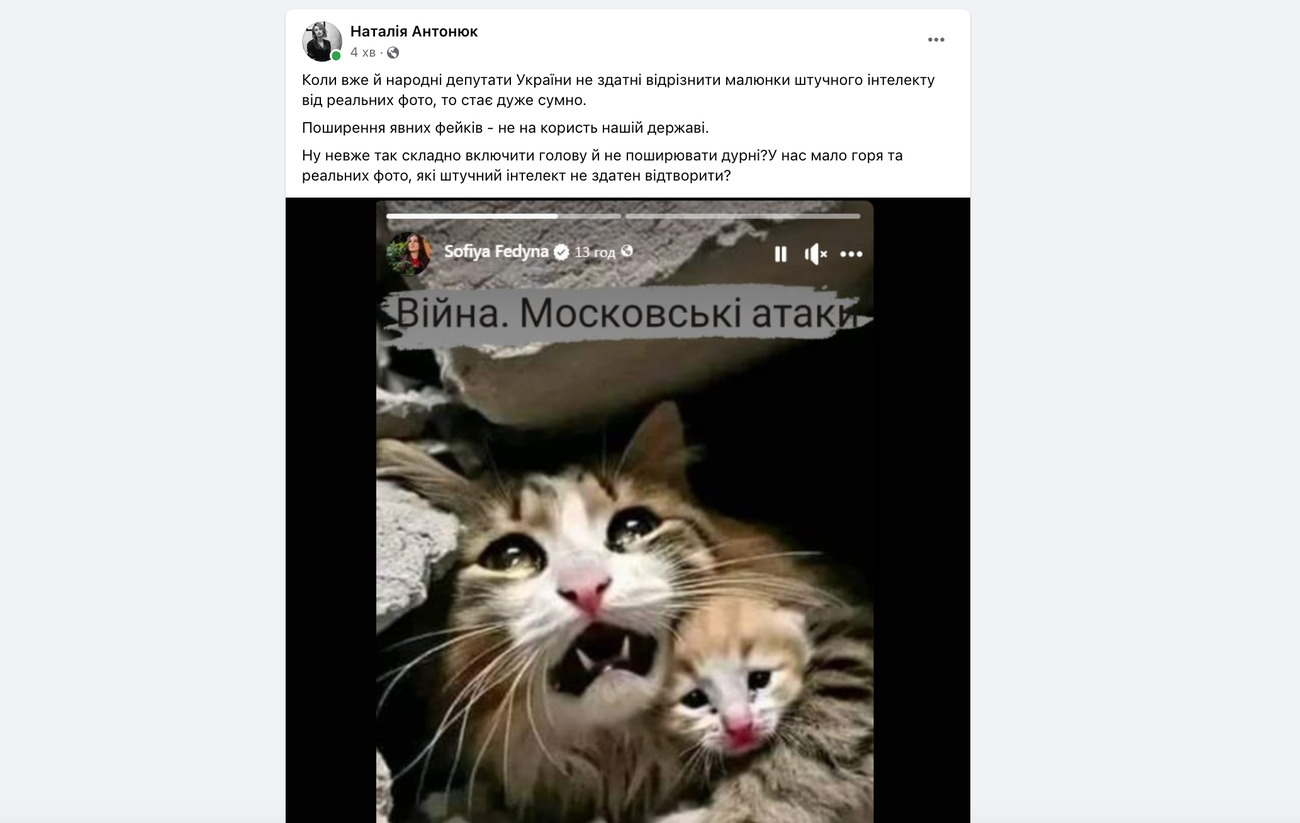

Пользователи социальных сетей распространяют фотографии, на которых якобы изображены два кота в панике под завалами. Однако изображение было создано искусственным интеллектом. Интересно, что на иллюстрации животные изображены якобы в Секторе Газа, однако украинцы утверждают, что фотографии настоящие и сделанные в Украине.

Так, украинцы опубликовали сотни сообщений со сгенерированными фотографиями. Соцсети сочувствуют животным и акцентирует внимание на страданиях от войны. Такие посты получили тысячи лайков и сотни распространений.

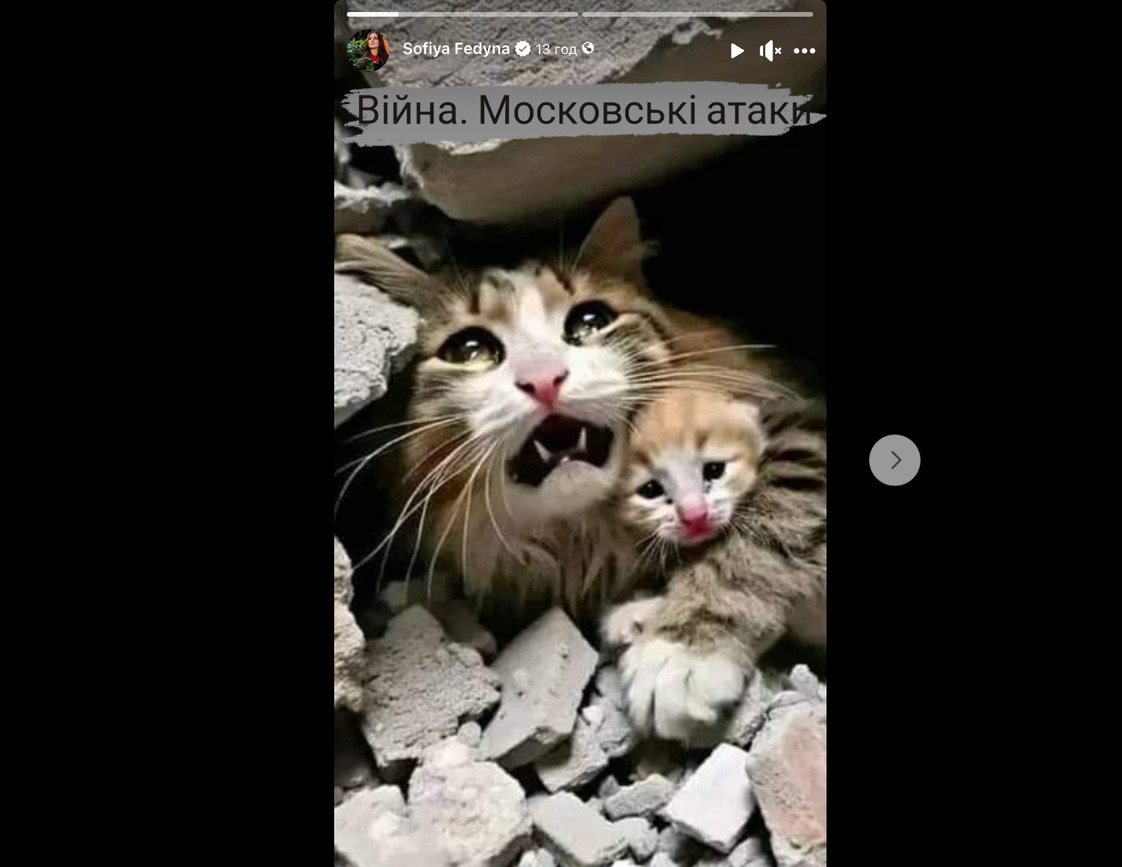

Некоторые утверждали, что изображенные на картинке котики пострадали из-за российских атак на Украину. Так, народная депутат от фракции «Европейская солидарность» София Федина также запостила сгенерированные ИИ фотографии, обвинив оккупантов.

Распространение этих фотографий произошло в то время, когда министерство здравоохранения ХАМАС объявило, что количество погибших от израильских бомбардировок и наземных операций в секторе Газа возросло до 27 тыс. погибших, в том числе женщин и детей. В министерстве подтвердили, что ряд пострадавших до сих пор находятся под завалами и на дорогах, а «оккупация не дает до них добраться бригадам скорой помощи и гражданской обороны».

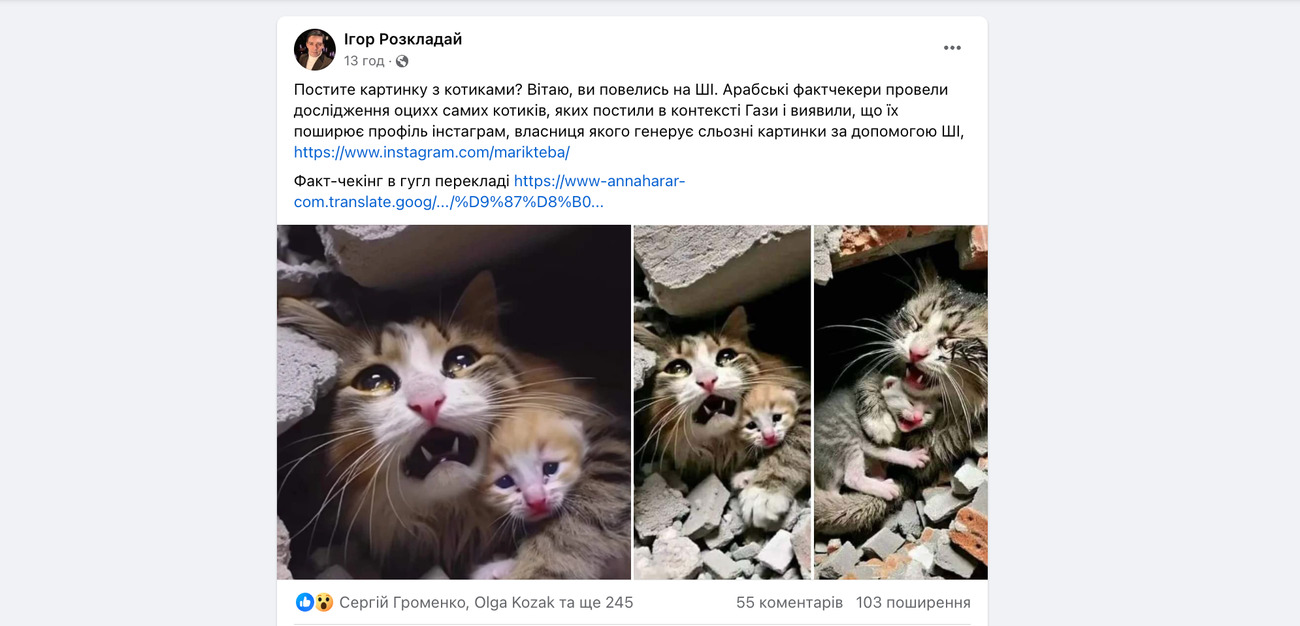

Фотографии кошек в Газе первой распространила в Instagram женщина, работающая над разработкой изображений в своем аккаунте с помощью программ искусственного интеллекта.

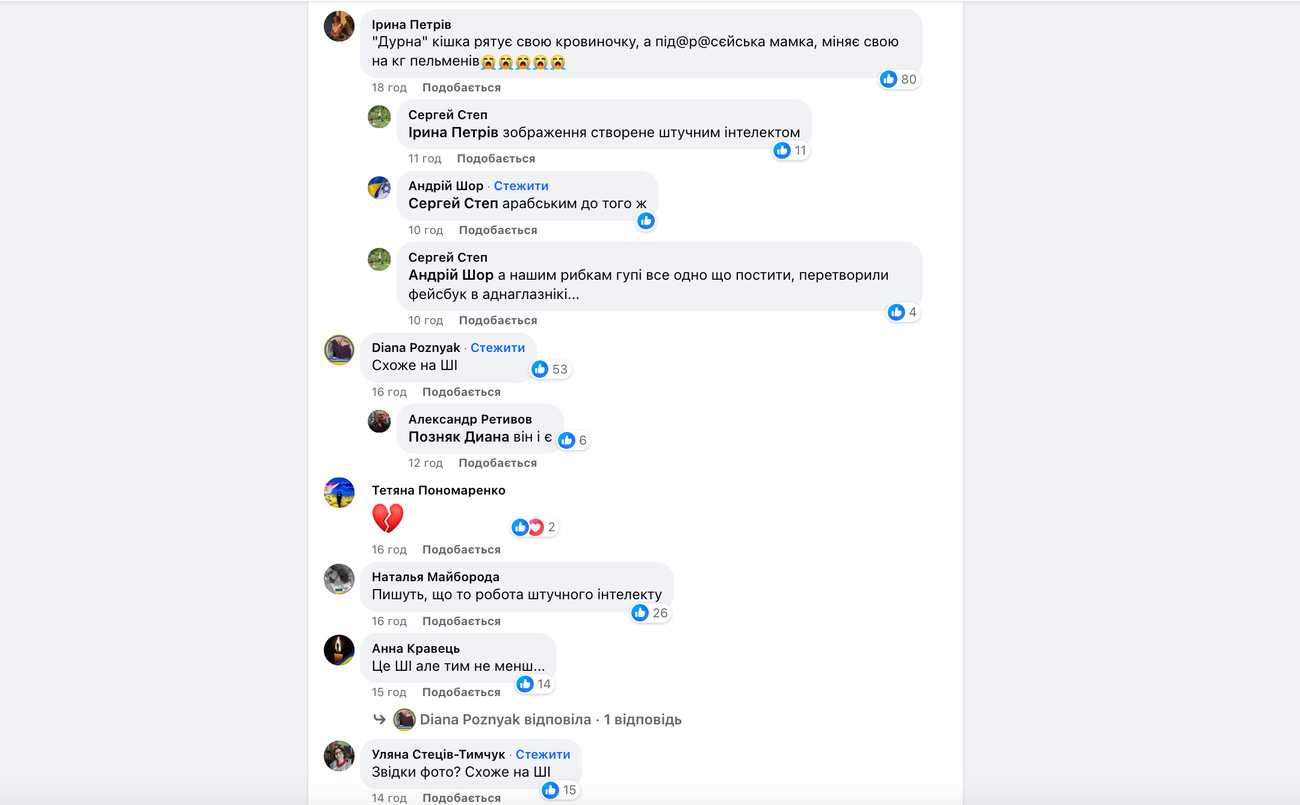

Заметим, многие украинцы распознали работу ИИ.

Под сообщениями с фейковым изображением десятки комментариев сознательных украинцев.

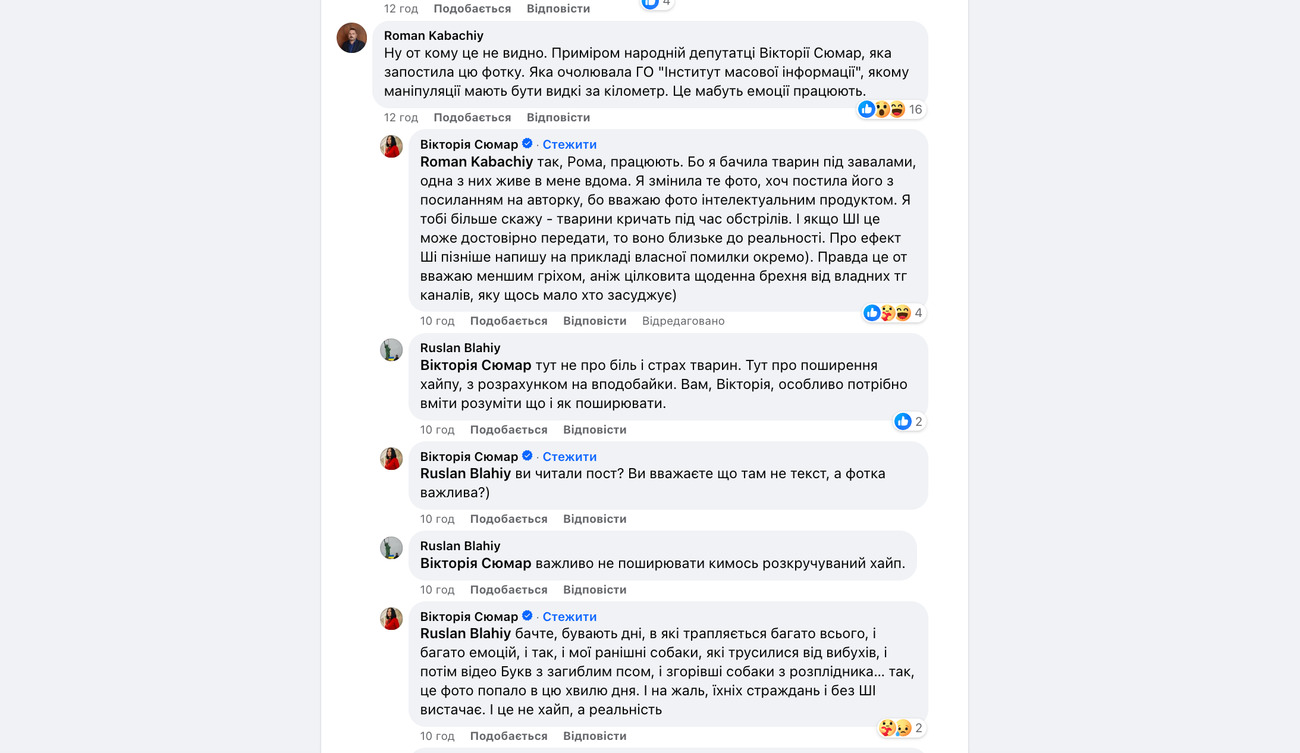

Между некоторыми пользователями возникли ожесточенные дискуссии. Так, народный депутат от «Европейской солидарности» Виктория Сюмар также поверила в подлинность бедных кошек.

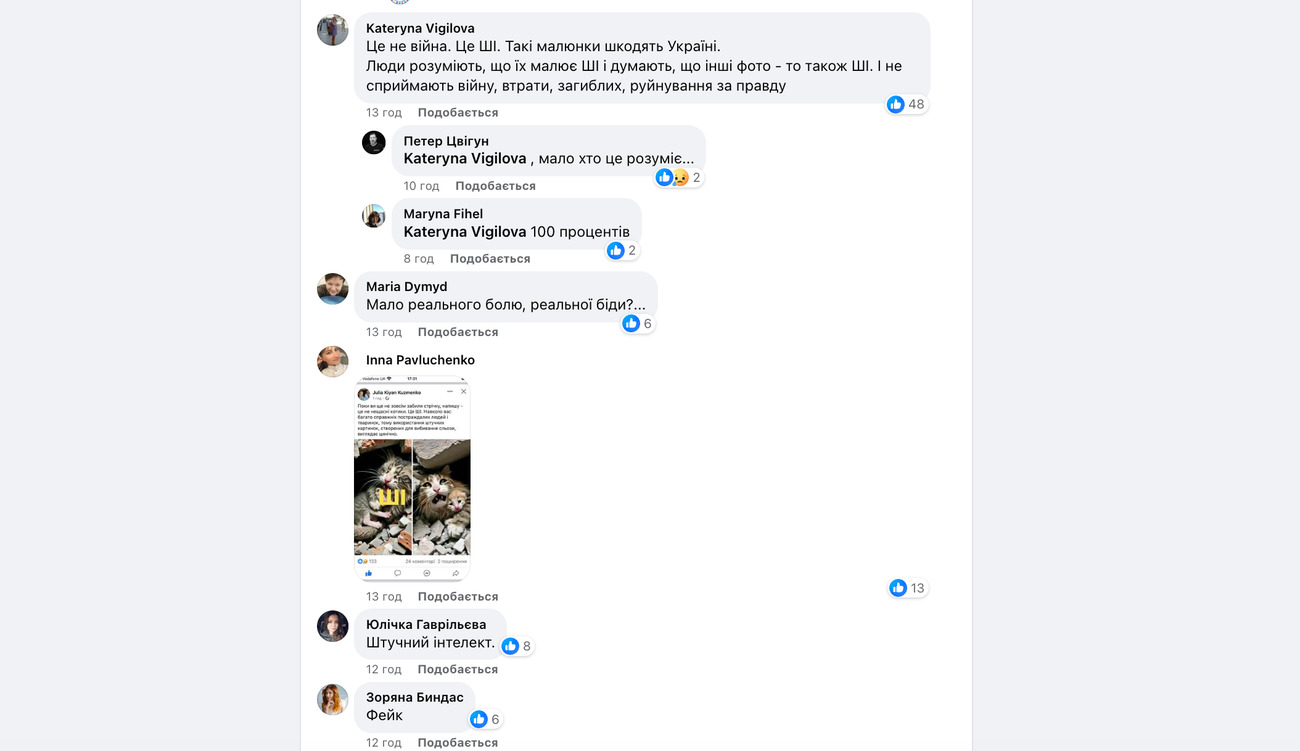

Некоторые украинцы понимают глобальность проблемы и видят в этом нешуточные последствия. Ведь граница между реальным и виртуальным все больше размывается.

Искусственный интеллект стирает границу между реальностью и выдумкой. Созданные им изображения очень трудно отличить от реальных. Однако все же пока это возможно.

Еще никогда не было так просто олицетворять фантазии. Для этого необходим только доступ к интернету и инструментам искусственного интеллекта (ИИ). Нейросети в считанные секунды сгенерируют фотореалистическую картинку или создадут оригинальное изображение, причем высокого качества.

Нейросеть способна самостоятельно делать совершенно новый контент или трансформировать уже имеющийся: изменять цвета, форму и расположение предметов на картинке, добавлять новые элементы и удалять ненужные, перерисовывать изображения в другом стиле, жанре и т.д.

Услуги искусственного интеллекта почти ничего не стоят, а иногда они вообще бесплатные. Именно поэтому сегодня в соцсетях так много разных изображений, мгновенно распространяющихся по всему миру. Бизнесменам, маркетологам, дизайнерам, копирайтерам и многим другим нейросетям действительно облегчают работу и освобождают время. Но в то же время ИИ стали все чаще стали использовать в ущерб человеку для пропаганды и дезинформации.

На протяжении последних нескольких месяцев в интернете все чаще появляются фотографии, созданные с помощью искусственного интеллекта или им самим. Все эти снимки выглядят очень правдоподобными, если говорить об их техническом исполнении. При этом на них – события, которых действительно не было. Это говорит о том, что все более совершенные алгоритмы и нейронные сети сейчас способны стереть границу между реальностью и выдумкой. Фотографии большинства зрелищных событий типа автомобильных гонок или космических полетов, а также арестов знаменитостей пользователи могут достаточно быстро проверить. Достаточно обратиться к авторитетным СМИ или другим источникам в сети, которые заслуживают доверия.

Наиболее проблематичными и опасными с точки зрения распространения дезинформации картинки, в которых изображены менее известные люди. Однако в настоящее время можно отличить настоящие фотографии от искусственно созданных. Ведь так же как и человеку, ИИ свойственно ошибаться. Как обнаружить манипуляцию?

1. Масштаб и детали

Многие изображения, созданные ИИ, на первый взгляд, очень реальны. Распознать подлог можно только при рассмотрении вблизи. Для этого найдите версии снимка с максимально возможным разрешением и увеличьте детали. Тогда и будут видны возможные несоответствия, нестыковка линий и теней, ошибки цвета, клоны изображения и т.д.

2. Источник изображения

Если вы не уверены, реально ли изображение, попробуйте больше узнать о его происхождении. К примеру, иногда другие пользователи делятся своими мыслями в комментариях, и благодаря этому можно выйти на источник или первую публикацию картинки. Может помочь и обратный поиск изображения. Для этого загрузите изображения в такие инструменты как обратный поиск изображений Google или TinEye. В результате часто находится дополнительная информация о снимке, а иногда – и его происхождении. Возможно, авторитетные источники уже совершили факт-чекинг, и тогда поисковик выдаст разъяснения в результатах поиска.

3. Пропорции тела

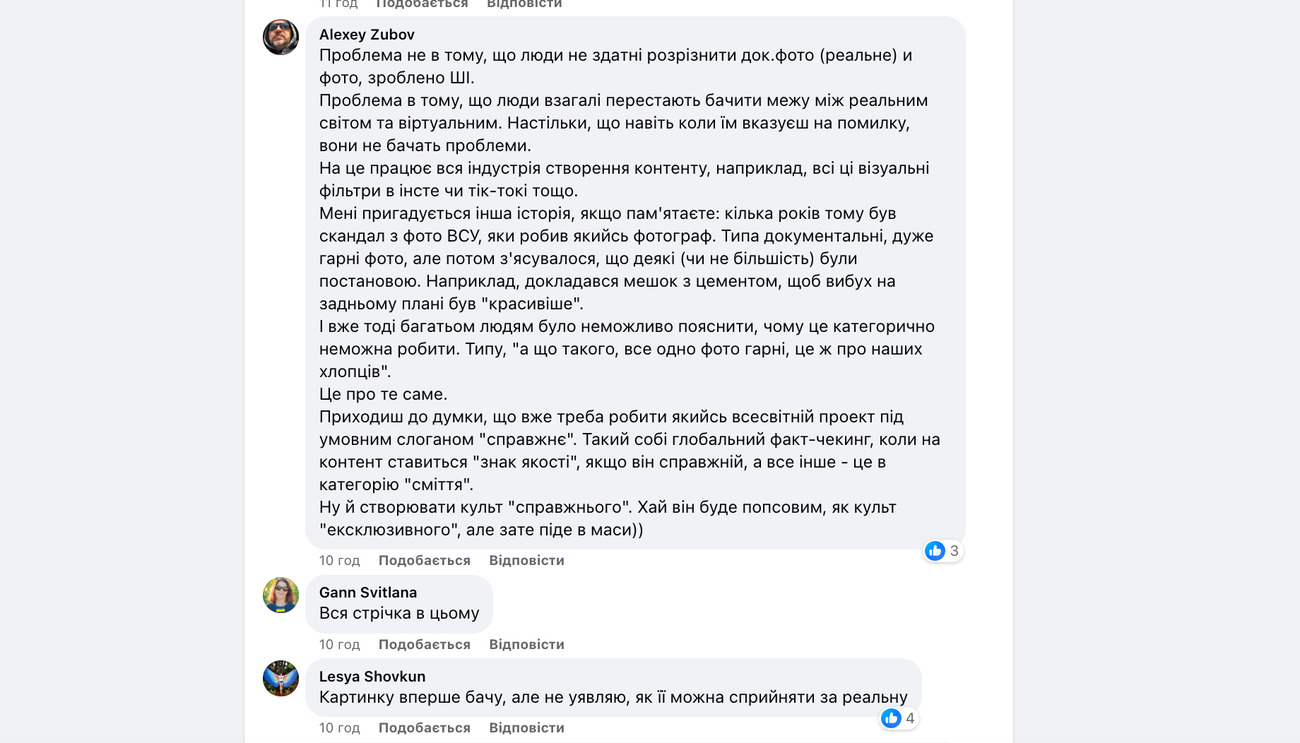

Правильные ли пропорции тела изображенных людей? Именно в этом пункте ИИ часто совершает ошибки: сгенерированные руки могут быть слишком маленькими, а пальцы – слишком длинными. Или голова и ноги не соответствуют остальному телу. Например, на фейковой фотографии Путина и Си Цзиньпина задний ботинок российского президента слишком велик и широк. Ступня той же ноги кажется удлиненной. Да и голова при внимательном рассмотрении слишком велика и непропорциональна телу.

4. Типичные ошибки ИИ

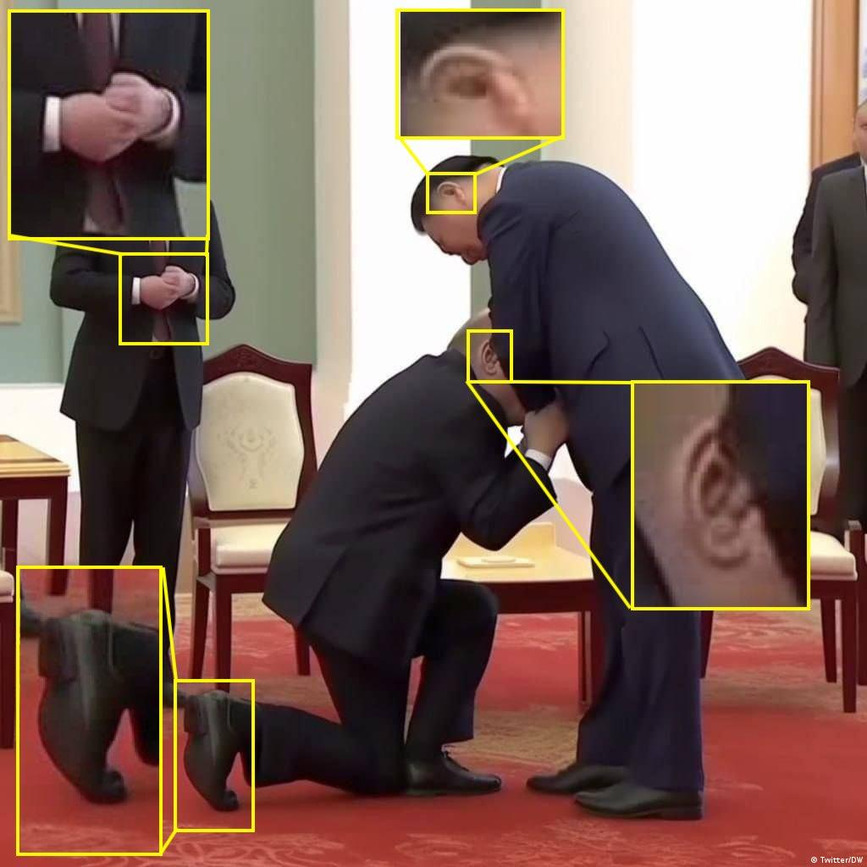

В настоящее время некоторые программы обработки изображений с ИИ никак не научатся правильно изображать части тела человека, особенно руки. Часто они рисуют шестой палец. Или отнимают пятый. Как, например, у полицейского слева от Путина, на сгенерированном изображении с его арестом. Та же ошибка и на снимке Папы Франциска в белом пуховике – на его левой руке в белой перчатке всего четыре пальца, а на снимке без перчатки пальцы непропорционально длинные.

Очень часто у «поддельных людей» бывает слишком много зубов. Или удивительной формы уши и глаза. Очки, которые любит одевать людям ИИ, как правило, деформированы и неестественно сидят. Отображения, такие как окна, забравшие шлемы и т.п., тоже создают проблемы программам ИИ и облегчают их разоблачение.

5. Не кажется ли изображение неестественным?

Часто картинки ИИ слишком идеальны, чтобы быть правдой. Доверьтесь своей интуиции: может ли такое безупречное с эстетической точки зрения изображение быть реальным? Если говорить о портретных фотографиях, то подозрение может вызвать слишком гладкая кожа человека, слишком ровные и гармоничные пропорции лица, безупречные зубы и волосы. Следует внимательнее присмотреться к фотографиям, идеальный художественный вид которых трудно достичь даже профессиональным фотографам при съемке в студии и последующей обработке изображения. ИИ создает идеалы, которые должны всем понравиться.

6. Фон изображения

На фоне объекты могут отображаться искаженными, например, фонарями. Часто случается, что программы ИИ клонируют людей и предметы, используя их на одном снимке дважды. Кроме того, фон нередко бывает размытым.

Напомним, пропагандисты Путина привлекли искусственный интеллект к распространению лжи. Однако нейросеть обманула российского пропагандиста, желавшего высмеять Байдена.

Кроме того, искусственный интеллект показал, как выглядел бы Путин в 2030 году.

Ранее сообщалось, что в ВСУ «мобилизуют» искусственный интеллект. Это позволит сократить использование боеприпасов.

Коментарі — 0