Безугла представила Залужному план перемоги над РФ? Як уберегтися від діпфейків

Деякі користувачі мережі схвильовані прогресом технологій, адже більшість українців не мають критичного мислення

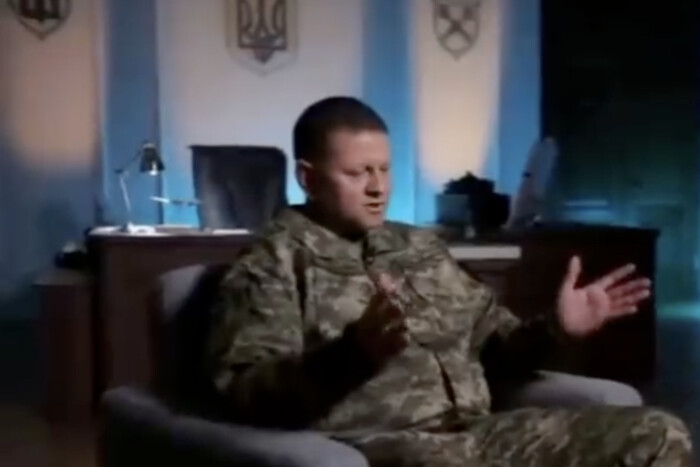

Українці за допомогою штучного інтелекту змусили народну депутатку від «Слуги народу» Мар’яну Безуглу пояснюватися перед головнокомандувачем ЗСУ Валерієм Залужним. Приводом для цього став скандал, спровокований черговою критикою нардепки на адресу військового керівництва країни.

Зокрема, Безугла, яка також є членом парламентського комітету з національної безпеки, оборони та розвідки, зажадала відставки Залужного, оскільки, за її словами, він «не може надати жодного задуму на 2024 рік». Серед українських користувачів така позиція нардепки викликала роздратування, оскільки більшість із них вважає її абсолютно некомпетентною у таких питаннях.

На цьому тлі у соцмережах почали активно поширювати відео з нібито особистою зустріччю Залужного з Безуглою, на якому вона, завдяки втручанню штучного інтелекту, уже сама представляє йому свій «геніальний» план як швидко перемогти РФ.

«На мій погляд, це очевидні речі, Валерію Федоровичу. Спочатку ми залітаємо на танках. Бах-бах-бах. Потім літаки летять такі, і ракети по всіх пускають. А потім наші хлопці з автоматами. Тра-та-та, і всіх росіян убивають. Усе вибухає, як у фільмі Армагеддон із Брюсом Віллісом. Ось так потрібно перемагати. Соромно, що ви не розбираєтеся в таких простих речах», – заявила переозвучена Безугла. І хоча її план і здається надійним, як швейцарський годинник, фейковому Залужному він не сподобався. Наприкінці відео також з'явився речник Повітряних сил Збройних сил України Юрій Ігнат.

На діпфейк відреагували соцмережі. Деякі користувачі схвильовані прогресом технологій, адже більшість українців не мають критичного мислення. Тож варто звертати увагу на можливості ШІ та підвищувати обізнаність населення.

Та все ж чимало українців реагують на фальшиве відео з гумором та розуміють, що його створили не зі злими помислами. Дехто наголошує, що репутацію Головнокомандувача неможливо зіпсувати, навіть якби кадри були справжніми, адже у вуста Залужного та Ігната вклали те, що думають і хочуть сказати Безуглій більшість українців.

Загрози діпфейків

Хоч фейковий відеоролик з Валерієм Залужним і Мар'яною Безуглою є жартівлим, чимало українців (особливо літні люди) повірили в його автентичність. Якість відео та аудіо, виготовлених штучним інтелектом, зростає нелінійно. Досить скоро фахівці не зможуть відрізнити фейк від справжнього. Проте навіть зараз експертів, які досліджують діпфейки, ніхто не слухає, а каналів доступу до авдиторії вони не мають. На тлі зростання загроз штучного інтелекту «Главком» зібрав основне про діпфейки та створив добірку порад як їх розпізнати.

Поняття «діпфейк» перестало бути чимось новим з моменту створення інтернету. Загалом діпфейк розуміється, як методика синтезу зображень різних людей за допомогою штучного інтелекту. Вона використовується для накладання вже існуючих відео чи зображень на початкові. Здебільшого, аби створити оманливе уявлення про когось або щось, поширення чорного піару та дезінформації тощо.

Діпфейки – наступне покоління фейкових новин. Нині відредагувати промову людини на відео так само легко, як і редагувати текст: копіювати, вирізати, додавати чи видаляти слова з вуст людини прямо у відео. Для сфери кіноіндустрії, наприклад, це суттєвий прогрес – адже якщо актор помилиться або його фразу треба замінити, тепер не треба витрачати ресурси й перезнімати все. Усе, що потрібно, – замінити сценарій, і алгоритм сам зробить всю необхідну роботу.

Поняття діпфейк означає глибинне навчання та підробку (Deep Learning + Fakes є Deepfakes). Відеодіпфейк повністю відтворює людину за допомогою алгоритмів машинного навчання. Розвиток комп'ютерних технологій на базі глибинного навчання дозволяє програмам «вчитися» завдяки штучним нейронним мережам. Методика синтезу зображення працює на основі штучного інтелекту. Це поєднує зображення людини, накладає одне відео на інше.

Комп'ютерна програма аналізує фото однієї людини, збирає дані та відтворює зображення. Далі таке створене фото або цифрову «маску» спеціалісти накладають на відео. Крім цього, програма може синхронізувати голос, жести й рухи. У результаті гладачі спостерігають персонаж, який повістю нагадує реальну людину.

«На жаль, такі технології завжди приваблюватимуть поганих людей», – наголосив вчений зі Стенфорда Огад Фрід. Мова йде про небезпеку легкого створення так званих діпфейків, про загрозу яких говорять уже не один рік. Якісні діпфейки потроху стає складніше виявити неозброєним оком. Технологію можуть використовувати для сприяння насильству, саботування виборів, шантажу чи будь-яких інших провокацій.

Синонім діпфейку – дезінформація. Новітні технології активно використовують з метою обману та шахрайства. У цьому полягає велика загроза, адже виникає можливість маніпулювати цілим народом. Основна мета діпфейку – це дезорієнтація та дезінформація. Таким чином шахраї намагаються вселити «уявну» правду.

З іншого боку, у діпфейків є і позитивні сторони, кажуть експерти. Наприклад, історію у школі дітям може розповідати не вчитель, а сам Богдан Хмельницький з екранів моніторів – і при цьому взаємодіяти з аудиторією. Це сприятиме підвищенню інтересу дітей до навчання.

Як відрізнити діпфейк від справжнього відео

Поки найважливіше завдання для людей – бути пильними й не довіряти одразу всьому, що вони бачать в інтернеті. Відрізнити справжнє відео від фейкового все ж можливо. Для цього слід бути уважним та звернути увагу на такі деталі:

- колір шкіри – може бути не схожим на справжній;

- краї маски навколо обличчя. Іноді відео недосконалі, тому можна помітити очевидні недоліки відтворення реальної людини;

- оклюзія обличчя спотворює предмети або закриває їх;

- розмите обличчя. Якщо добре придивитися, то обличчя персонажа може бути розмитим, і це не пов'язано з якістю відео;

- легке мерехтіння. Інколи алгоритми не можуть до кінця «зчитати» та відтворити зображення людини. Це секундні мерехтіння мають бути помітними на екрані;

- різна фокусна відстань;

- невідповідність зображення;

- різне тло.

Разом із тим, щоб протидіяти діпфейкам можна скористатись загальними правилами протидії дезінформації:

- Побачили щось скандальне – не поширюйте! Адже саме це і є мета усіх фейків.

- Подумайте про контекст. Чи не є щось нелогічним в інформації на відео? Якщо це тотальна «зрада» або «перемога» – це ще один привід додатково перевірити. Також у фейках часто немає посилання на авторитетне джерело.

- Перевірте інформацію у пошуку. Якщо інформація резонансна і про це не писали перевірені джерела – швидше за все, це – фейк.

Коментарі — 0